SKT FLY AI

[SKT FLY AI] 청각장애인을 위한 AI 기반 실시간 양방향 수어 번역 앱

48965

2024. 11. 12. 20:11

개발 기간 : 2024.07.29~2024.08.30 (1개월)

팀 구성 : AI 개발 2명, 프론트엔드 개발 1명, MLOps 1명 (총 4명)

본인 역할 : MLOps

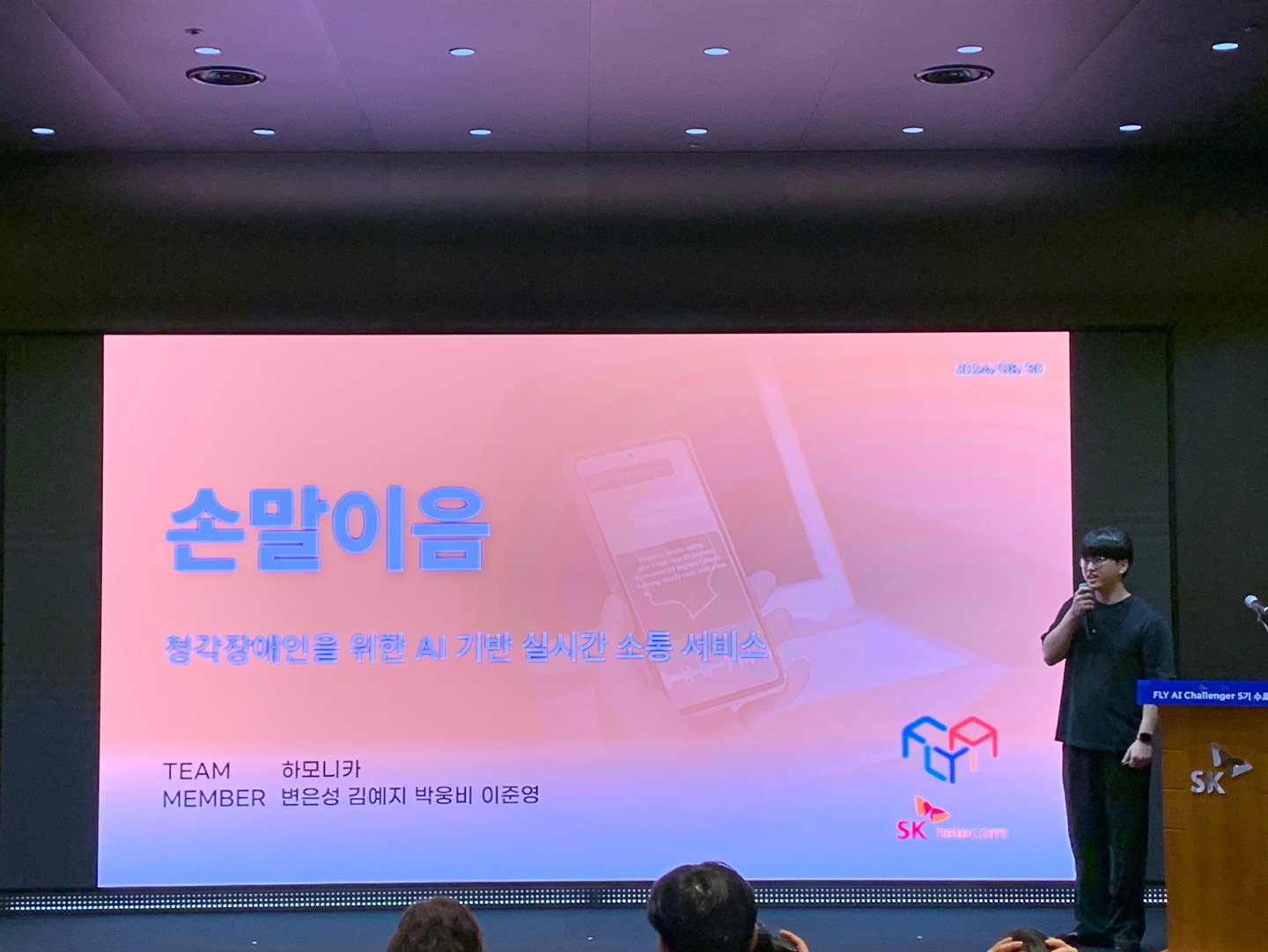

프로젝트 배너

https://www.skttechacademy.com/nonmember/flyAi/flyAiProjectReviewDetail

프레임워크 및 핵심 라이브러리

- FastAPI 0.112.2

- Mediapipe

- SQLAlchemy

- Pytorch 2.2.2

- SpringBoot 3.2.8

- Spring Data JPA

AI Model

- CNN Base Model (.pth.tar)

- FastText(cc.ko.300.bin)

DB

- Postgresql (pgvector)

Infra

- AWS RDS

- AWS S3

- Chat GPT API

- Ngrock

프로젝트 개요

SKT FLY AI 해커톤에서 AI를 활용한 ESG 관련 서비스 개발을 주제로, 청각장애인을 위한 AI 기반 실시간 양방향 수어 번역 앱을 개발하였습니다.

프로젝트 내에서 본인의 역할 - MLOps, 팀장

(1) Sign2Speech 기능 구현

- 학습된 CNN 모델 서빙 로직 구현 (FastAPI)

- Chat GPT API 연동 파이프라인 구축

(2) Speech2Sign 기능 구현

- 국립수어사전 공공데이터 API를 활용하여 16,500개의 수어 글로스와 수어 영상을 매핑한 데이터베이스를 구축.

- 벡터 임베딩 모델 FastText 활용한 벡터 DB 구축

- Pgvector 활용 유사도 검색 기능 구현 (SpringBoot)

- Mediapipe 활용 저장된 수어 영상 내 57개의 관절 키포인트 프레임 단위 추출 로직 개발(FastAPI)

- DB에 저장된 키포인트 파일을 읽어 수어 영상을 생성하는 기능 구현 (FastAPI)

시현 영상

+ 최종 성과 발표 (을지로 SKT 타워 수펙스홀)